我怀疑有些人会指责我标题党。其他人会说,这并不夸张 - 绝大多数人在最初尝试 AI 时都会失败,但没关系,学习的过程是有价值的。从某种程度上来说,他们都对 - 但我认为企业失败的原因值得探讨,并可能让一些读者在走得太远之前重新评估一下。

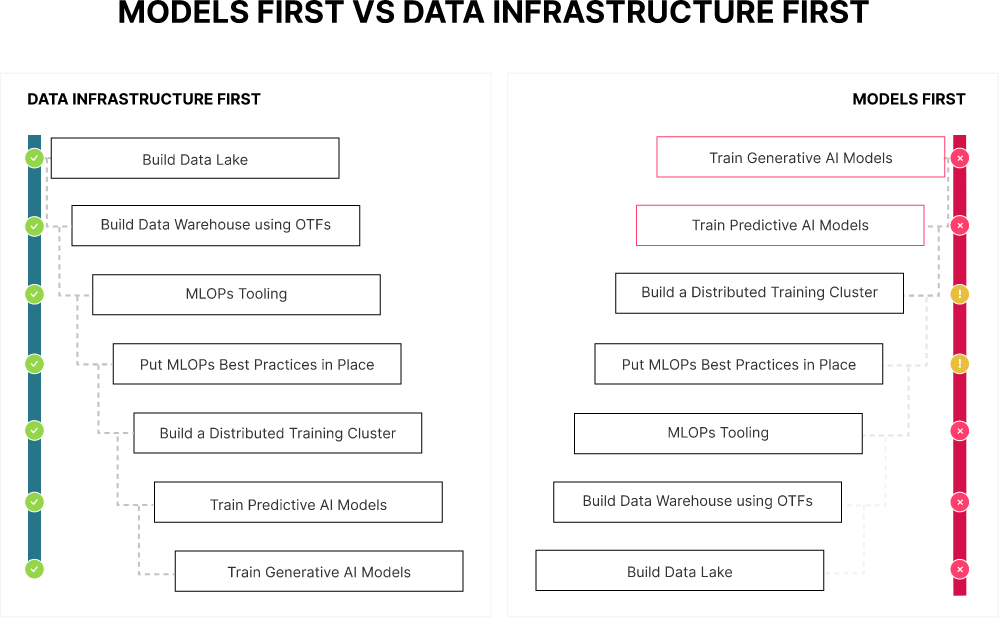

2024 年,企业 AI 战略将会失败,因为它们专注于模型,而不是数据。你选择什么基础模型远不如训练它的数据重要。如果你的数据和数据基础设施建立在错误的基础之上,即使你在边缘选择了一个向量数据库,它也意义不大。

这可能看起来不言而喻,但我们与企业(非常大的企业,拥有许多聪明的人)交流过,我们可以肯定地说,组织的惯性导致其中一些企业选择模型优先,数据其次。这是一个严重的错误。

你必须从数据开始。构建一个合适的数据基础设施。然后考虑你的模型。

如果你想购买一些 GPU 并重用现有的数据基础设施,那你将会失败。你现有的数据基础设施很可能是一堆 SAN/NAS 设备。它们无法扩展。结果是,你将只训练公司一小部分的数据,并且只会获得一小部分价值。链条的强度取决于它最薄弱的环节 - 你的 AI/ML 基础设施的速度仅取决于最慢的组件。如果你使用 GPU 训练机器学习模型,那么你的薄弱环节可能是你的存储解决方案。Keith Pijanowski 将其称为“饥饿的 GPU 问题”。饥饿的 GPU 问题发生在你的网络或存储解决方案无法以足够快的速度将训练数据提供给你的训练逻辑,从而无法充分利用 GPU 的时候。

我们有点超前了。让我们从数据应该是什么样子开始。

- 完整且正确:如果你愿意,你可以称之为“干净”的数据。数据清洗的程度会显著影响 LLM 中的底层计算和向量表示。高质量语料库对于微调和 RAG 至关重要。它必须包含代表组织正确和真实信息的文档/内容,才能生成正确的输出。这对训练效率有影响。不完整的数据集会阻碍模型的学习过程,导致训练效率低下,以及对新数据的泛化能力差。最后,还有偏差放大问题。不正确的数据,尤其是系统性偏差数据,会导致模型内部偏差的放大,影响公平性和伦理考虑。

- 扩展性:这涉及到拥有足够的数据。如果你的基础设施导致你人为地限制了可使用的数据量和/或类型,那么它将限制你产生的价值。例如,在检索增强生成中,拥有大量数据允许 LLM 从大量的知识库中提取信息,使其能够提供更细致入微和更明智的答案,类似于咨询一个藏书丰富的图书馆。这同样适用于将 AI 用于日志分析。是的,大多数情况下,价值在于最近的数据,但这并不意味着价值不扩展到更旧、更大的数据窗口。你的基础设施决策会影响你的模型输出,如果它们限制了你能够分析的数据量。

- 时效性:虽然我们刚刚讨论了更长的窗口和更多数据 - 但显然存在一个限制。这些数据不能过时,以至于不再有效。领域特定的专业知识在这里很重要。例如,对于技术、金融或当前事件等动态领域,超过 6-12 个月的旧数据可能被认为过于陈旧。相反,对于稳定或历史领域,几年前的数据仍然有价值(例如,关于伯罗奔尼撒战争的全新信息很少)。至关重要的是将数据的年龄与 LLM 模型的具体用例以及相关领域的变革速度相匹配。

- 一致性:数据一致性是指数据集内数据的统一性、准确性和可靠性。它确保数据在其整个生命周期中保持不变,从收集到处理和分析,为 AI 模型学习和进行预测提供一个稳定和一致的基础。对于 LLM,不一致的数据会扰乱对语言模式的学习,导致不准确的文本生成或理解。对于拓扑数据分析等方法,它分析数据的形状和结构,不一致会导致拓扑洞察力的偏差,影响对复杂数据集的解释。本质上,一致的数据类似于建筑的稳定基础,确保 AI 的“结构”坚固稳固,并按预期运行。

- 唯一性:数据唯一性对于 LLM 很重要,因为它确保了一个多样化的训练集,增强了模型概括和理解不同语境的能力。独特的数据点可以防止过度拟合重复信息,使 LLM 能够发展更广泛的理解并生成更具创意、更准确的响应。它还可以用于模型的微调和 RAG。

这是一个“干净”数据的有效起点。接下来是你的数据基础设施选择。数据基础设施必须能够支持你的数据,而不是对其进行约束,这一点至关重要。你的数据基础设施不能“强迫”你只查看以行和列形式呈现的数据。你的数据基础设施不能限制你从视频或日志文件中获取什么信息。它必须能够支持这些操作。

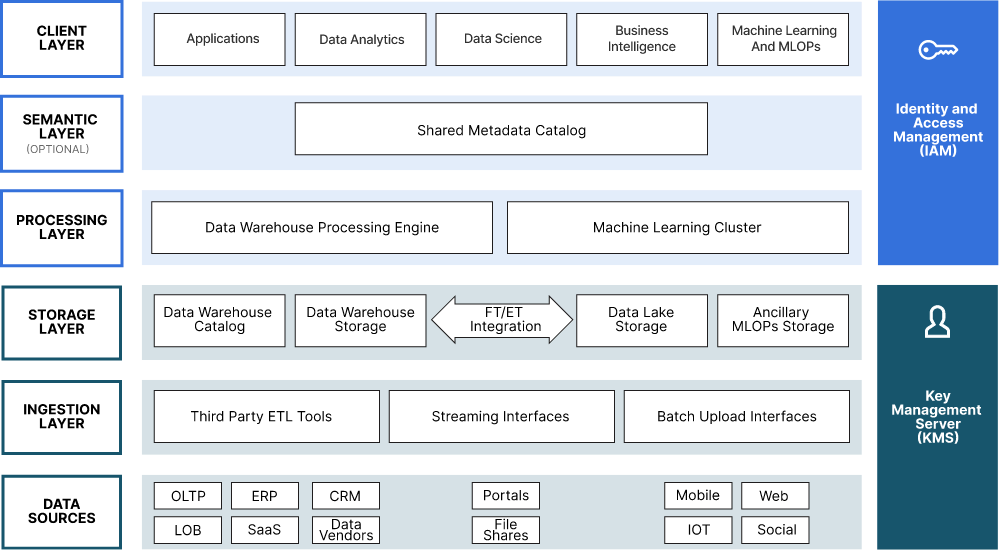

以下是一个现代数据湖的参考架构。将其用于 AI 和更多用途。

如果你愿意,你可以开始用 logo 填充它。使用 MinIO 之类工具的优势之一是,整个生态系统将开箱即用。MLflow、Tensorflow、Kubeflow、PyTorch、Ray - 你明白我的意思吧。

这里的重点是,你希望将所有数据存储在一个单一的存储库中(适当复制)。它可以实现更好的治理、访问控制和安全性。

这需要一个高度可扩展的工具,能够处理各种类型的数据。这将是一个对象存储(一个现代的对象存储,再说一遍,设备在这里没有多少用处)。

你希望它具有高性能(吞吐量和 IOPS),再次,一个现代的对象存储是答案。你希望它简单 - 因为扩展需要简单。你希望它软件定义。你需要的规模需要商品硬件来使经济效益得以实现。设备是一个糟糕的选择。

你希望你能够控制它。这是你的数据,它是你的整个 AI 工作的基础。你不能将其外包给那些可能在几个季度后与你竞争的人。构建一个你能够控制的 AI 现代数据湖。

你希望它是一个云原生的工具。Kubernetes 是云运营模型的操作系统。对容器化和编排原生 的数据基础设施实际上是一项要求。

这需要一个能够跨数据中心和地理位置进行复制(主动-主动)的解决方案。

可能需要在特定国家/地区存储一些数据,也需要对此进行调整。重点应该是很清楚的,数据要求定义了基础设施要求,而基础设施要求又决定了框架/模型。而不是反过来。从数据开始并向上工作的公司将会取得成功。这是构建一个功能性 AI 战略的基础。框架和模型很重要,但数据才是重中之重。我们正在为一个以数据为中心的世界而努力,事实上,我们已经努力了将近十年。这就是为什么 AI 生态系统能够与我们无缝集成。要了解更多信息,请查看我们的 AI 和 ML 解决方案页面。它深入介绍了使我们成为全球 AI 架构师首选的特性、功能和性能。